2026년 1월 2일Luke

캐럿 노트북 LM: 솔라 100B 의혹제기로 본 소버린 AI와 오픈소스의 미래

업스테이지 솔라 100B 모델을 둘러싼 기술적 논의를 통해, 진정한 소버린 AI가 나아갈 길과 오픈소스 공개 검증의 중요성을 신뢰할 수 있는 AI 동료를 지향하는 캐럿의 관점에서 짚어봅니다.

최근 국내 AI 커뮤니티는 업스테이지의 Solar 100B 모델을 둘러싼 기술적 논의로 뜨겁습니다. 이 모델이 중국의 한 오픈소스 모델에서 파생되었다는 주장이 제기되면서, 기술적 검증의 중요성이 그 어느 때보다 부각되고 있습니다.

이번 논의는 단순히 한 기업의 모델을 넘어, 진정한 **'소버린 AI(Sovereign AI)'**란 무엇이며, 글로벌 오픈소스 생태계와의 건강한 연대가 왜 필수적인지에 대한 중요한 질문을 우리 모두에게 던지고 있습니다. 업스테이지의 투명한 대응 약속과 커뮤니티의 자발적인 참여는 국내 AI 생태계가 함께 성장하는 건강한 기술 토론의 장을 열어주었습니다.

저희 캐럿은 이번 주제를 더 깊이 있게 다루고자, 캐럿 노트북 LM(Caret NotebookLM)을 활용해 두 편의 영상을 제작했습니다.

- 오버뷰:

- 대담:

두 영상은 저희가 오픈소스로 공개한 NotebookLM to YouTube 프로젝트를 활용해 제작되었습니다. 앞으로도 캐럿 블로그를 통해 관련 소식을 꾸준히 공유하겠습니다.

캐럿의 관점: 신뢰할 수 있는 AI 동료를 향하여

물론, 업스테이지와 같은 거대 모델을 만드는 기업과 저희처럼 이제 막 첫걸음을 뗀 스타트업을 직접 비교하기는 어렵습니다. 솔직히 말해, 이 뜨거운 논란에 숟가락을 얹는 것처럼 보일 수도 있겠습니다. 😅

하지만 저희는 'AI 동료'를 만드는 입장에서, 그리고 매일 AI를 사용하는 개발자의 입장에서 이번 논의가 남다르게 다가옵니다. AI 기술, 특히 소버린 AI의 발전에 있어 '신뢰'와 '투명성'이 얼마나 중요한지, 그리고 커뮤니티를 통한 공개적인 검증 과정이 기술 생태계를 얼마나 건강하게 만드는지 보여주는 좋은 사례이기 때문입니다.

저희 캐럿(Caret)이 안정성이 검증된 오픈소스 Cline을 기반으로 '함께 성장하는 AI 동료'를 꿈꾸는 이유도 바로 여기에 있습니다. AI가 개발자의 가장 가까운 동료가 되려면, 무엇보다 신뢰할 수 있어야 합니다. 그 신뢰는 소스코드를 공개하고 커뮤니티와 함께 발전하며 끊임없이 검증받는 투명한 과정 속에서만 단단해질 수 있습니다.

이번 논의가 소모적인 공방을 넘어, 업스테이지의 공개 검증 약속처럼 국내 AI 생태계 전체가 투명성과 개방성의 가치를 되새기고 함께 성장하는 계기가 되기를 바랍니다. 캐럿 역시 오픈소스 커뮤 니티의 일원으로서, 건강한 기술 생태계를 만드는 데 기여할 수 있는 도구와 문화를 만들어가겠습니다.

[검증 방송 후기] 모든 의혹을 증명으로 바꾼 '로그(Log)'의 힘

업스테이지의 기술 검증 방송을 통해, 그동안 제기되었던 의혹들이 모두 명확한 데이터와 로그로 증명되었습니다. 방송 전체 내용은 아래 원본 링크에서 다시 보실 수 있습니다.

개발자로서 이번 방송이 왜 결정적이었는지, 그리고 왜 기존의 지적들이 기술적 오해에서 비롯되었는지 방송에서 제시된 핵심 증거들을 순서대로 정리해 드립니다.

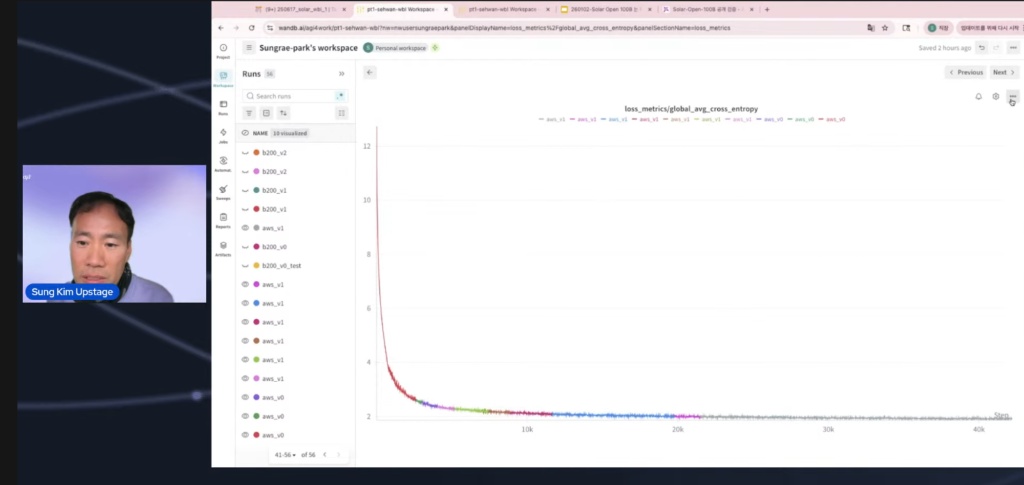

- 결정적 증거: 'From Scratch'를 입증하는 WandB 학습 로그 차트 가장 강력한 증거는 모델 학습 과정 전체를 기록하고 시각화한 **'WandB의 학습 로그 차트'**였습니다. 공개된 차트는 학습 가장 초기 체크포인트(Checkpoint)부터 Loss 값이 12에서 시작해 급격히 떨어지는 곡선을 명확히 보여주었습니다.

의미: 이미 학습된 모델(pre-trained model)의 체크포인트를 가져와 파인튜닝(Fine-tuning) 했다면, 초기 Loss가 이렇게 높을 수 없습니다(보통 2~3대에서 시작).

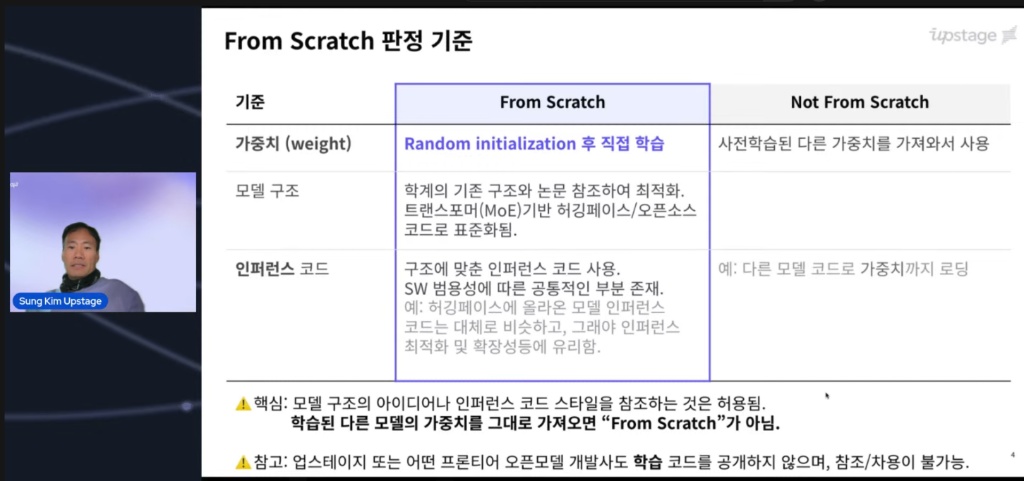

논란의 핵심은 '바닥부터(From Scratch)'의 기준이 어디냐는 것이었습니다. 많은 분들이 이 기준을 혼란스러워했기 때문에, 방송에서는 이 기준을 명확히 정의하는 것부터 시작했습니다. 백지 상태에서 학습을 시작하면 초기 손실(Loss) 값이 매우 높게 나타날 수밖에 없다는 점을 명확히 한 것입니다.

그리고 그 증거로 실제 학습 과정을 기록한 WandB 대시보드 스크린샷을 공개했습니다. 아래 이미지를 보면 초기 Loss 값이 매우 높게 시작하는 것을 볼 수 있는데, 이는 모델이 아무것도 모르는 백지 상태에서 학습을 시작했다는 강력한 물리적 증거입니다.

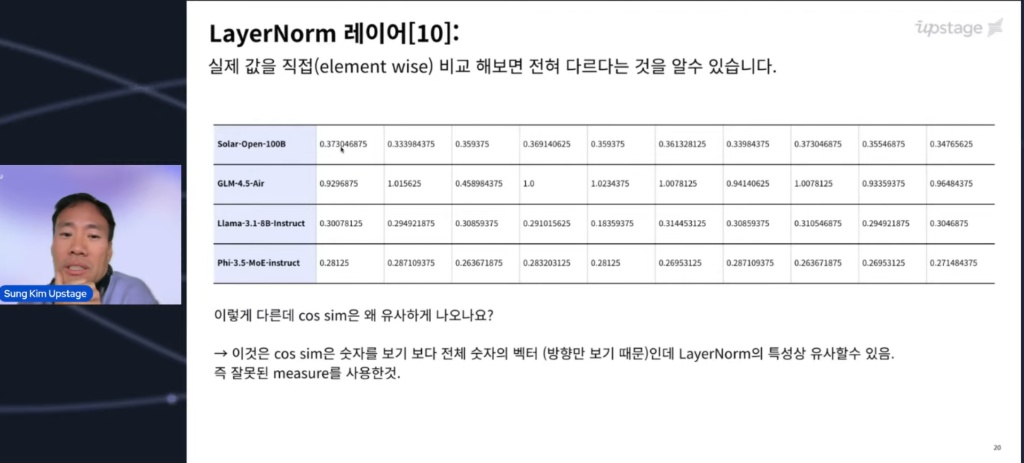

- "유사도"의 함정: 방향만 보고 크기를 보지 않았다 의혹의 시발점이었던 '코사인 유사도(Cosine Similarity)'가 왜 잘못된 잣대였는지도 증명되었습니다.

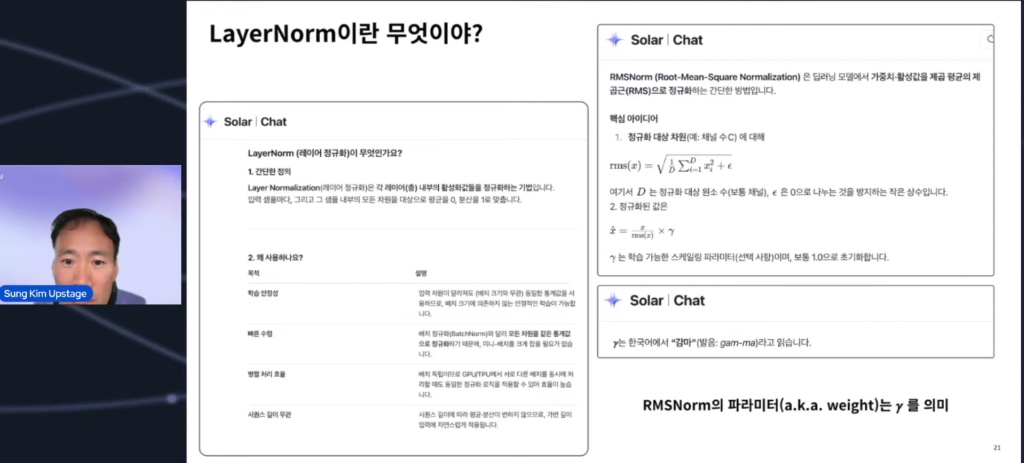

지표의 한계: 코사인 유사도는 벡터의 **'방향'**만 봅니다. 같은 아키텍처(설계도)를 사용했다면 레이어의 구조적 특성상 벡터의 방향은 비슷해질 수밖에 없습니다.

실제 비교: 실제로 가중치 값 하나하나(Element-wise)를 뜯어보니, 스케일(크기)과 구체적인 수치는 완전히 달랐습니다. "북극성을 가리킨다고 해서 모두 같은 손전등은 아니다"라는 사실이 확인된 셈입니다.

(재미있는 포인트로, 아래 이미지에는 당시 상황을 설명하던 업스테이지의 대화 내용이 '깨알 광고'처럼 포함되어 있습니다. 😅)

- 구조적 차별성: 베낀 것이 아니라 '개선'한 것

단순한 복제가 아님을 보여주는 구조적 특징들도 명확히 설명되었습니다.

GPT-OSS 120B와의 차이: 안정적인 학습을 위해 Shared Layer 등을 추가하여 구조를 보강했습니다. GLM과의 차이: 성능에 영향이 적다고 판단된 Dense Layer를 과감히 제거하는 등, 독자적인 엔지니어링 판단과 최적화가 들어갔음이 확인되었습니다.

마치며 이번 해명은 감정적인 호소가 아니라, 데이터와 로그, 그리고 아키텍처로 증명했다는 점에서 개발자 커뮤니티에 큰 신뢰를 주었습니다. 결국 "코드는 거짓말을 하지 않는다"는 진리가 다시 한번 확인된 순간이었습니다.

다른 글 더보기

2026년 첫 업데이트로 나노바나나 프로를 이용한 이미지 생성, 네이버 하이퍼클로바X 모델, AAIF 표준 Agents.md 지원 등 주요 기능이 추가된 Caret v0.4.4 릴리스 노트를 확인하세요.